18 avril 2011

Du boîtier à l’imprimante

Patrice FOIN

0.Récapitulatif

des opérations (aide mémoire).

(les numéros renvoient aux chapitres correspondants, il n’y a pas d’opération en 2. donc pas de 0.2.)

0.1.Déchargement de la carte mémoire sur l’ordinateur.

-dossier temporaire de déchargement

-éliminer les mauvaises photos et titrer les autres

-ne jamais traiter un original sans garder une copie

-faire des sauvegardes de temps à autre

-« faire le ménage » régulièrement (carte mémoire, corbeille de l’ordinateur)

0.3.Recadrage, redressement, balance des blancs

0.4.Travail dans l’espace des couleurs ; suivant les cas :

-Luminosité/Contraste puis Saturation

-Courbes puis Saturation (et éventuellement Luminosité/Contraste)

-ou simplement un peu de Saturation

0.5.Traitements sur le voisinage des pixels (Filtres)

-Renforcement de netteté (bien choisir le seuil)

-élimination du bruit éventuel

-sélection de la zone à traiter

-Flou gaussien

0.6.Retouches (taches de capteur,…)

0.7.Habillage (cadre, titre)

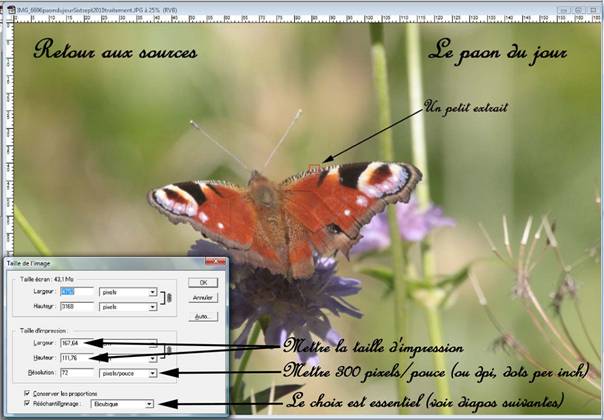

0.8.Changement de taille de l’image pour l’impression (choix du mode de rééchantillonnage)

0.9.Impression

Jusqu’à 4 niveaux de lecture !

-tout d’abord, ci-dessus, un récapitulatif des traitements préconisés dans l’ordre où ils doivent intervenir ;

-ensuite, un texte en caractère gras « tout public » expliquant en détail comment mettre en œuvre pratiquement les traitements en question ;

-enfin, en italique, les explications théoriques pour ceux qui veulent en savoir plus et comprendre le pourquoi des préconisations précédentes ; il demande un petit niveau en math et parfois en physique et il est complété si nécessaire par des explications d’un 4ème niveau beaucoup plus élevé.

Le but de ce texte est avant tout de fournir un guide pour le traitement simple d’une photo numérique à tous ceux qui sont démunis et ne savent pas par quel bout commencer, quelles que soient leurs connaissances de base. Ceci implique qu’un certain nombre d’affirmations ne soient pas étayées. Comme il est légitime que ceux qui ont la base de connaissances scientifiques suffisante aient accès aux explications théoriques et aux justifications, il comporte également celles-ci dans les niveaux en italique.

Ce texte est une partie d’un texte plus vaste sur la photographie numérique en cours de préparation. Comme rien n’est jamais parfait, j’attends quelques retours sur ses imperfections majeures pour l’améliorer avant de le diffuser plus largement. Il n’est donc pas souhaitable qu’il reçoive une trop large diffusion avant qu’un tout cohérent soit constitué et peaufiné. Merci de ne pas le faire circuler inconsidérément pour le moment. Merci également de me faire parvenir toute remarque permettant de l’améliorer.

Comme

on pourra le comprendre en approfondissant les explications de troisième

niveau, l’ordre des opérations à

réaliser n’est pas du tout indifférent. L’inverser peut conduire à des

dégradations du cliché non négligeables.

Il s’agit ici des opérations que je réalise personnellement sur les meilleures de mes photos courantes. Je privilégie ces opérations pour des raisons qui paraîtront évidentes à ceux qui liront le troisième niveau. Mais il n’y a pas d’exclusive et il m’arrive personnellement d’utiliser un peu toutes les autres fonctions disponibles dans les logiciels dont je dispose, soit pour tester leur efficacité, soit parce qu’elles me paraissent mieux adaptées à certains cas très particuliers. Pour réaliser des éditions particulièrement soignées, comme par exemple des photos de concours, les mêmes opérations peuvent être peaufinées et quelques autres outils utilisés. Le sujet de l’utilisation des calques et masques ne sera pratiquement pas abordé, non parce qu’il est trop compliqué ou inconnu de l’auteur mais parce que l’usage de tels outils est en général très nuisible à la qualité du résultat obtenu, pour des raisons dont le détail est donné en italique au paragraphe 4.2. Les calques et masques ont un usage autre, pour faire des photomontages ou des trucages que j’ai parfois appelé « bidouillages », sujet que je ne traite pas ici. Utilisons-les pour ce pour quoi ils ont été conçus et sont utiles !

En général, les termes désignant les traitements sont ceux communément utilisés dans Photoshop®, en tout cas la très ancienne version que j’utilise, ou encore dans GIMP2® (logiciel gratuit mais qui n’était pas directement disponible sur MAC à une date récente ; d’après l’ « Aide en ligne » de GIMP2, il serait possible d’installer ce logiciel sur MAC à l’aide de FINK ou encore DARWINORTS).

1.Déchargement

des photos.

1.1.Transfert proprement dit.

Je fais ici abstraction de la solution qui consiste à imprimer ou faire tirer directement les photos à partir de la carte mémoire utilisée par le boîtier. Cette opération peut se faire dans le commerce ou, si l’on dispose d’une imprimante, en reliant directement le boîtier à celle-ci par un câble généralement fourni. Si l’on ne veut pas faire plus, on en est exactement au même stade qu’avec la photo couleur en argentique, avec en moins la conservation de négatifs. Il n’y a alors pas lieu de s’étendre (et il peut s’agir d’une bonne solution pour celui qui débute et doit déjà son prendre son boîtier en main…). Le sujet traité ici est autre. Il s’agit de s’approprier effectivement les photos numériques fournies par le boîtier et d’en faire des choses intéressantes.

Même s’il en existe maintenant d’une grande capacité, une carte mémoire n’est pas un support de stockage. D’une part, elle ne permet en général pas toutes les opérations qu’un ordinateur peut faire avec un disque dur normal. En outre, le prix du stockage sur un tel support est élevé et sa conservation dans le temps assez aléatoire (la conservation dans le temps de ce type de support est rarement précisée et reste peu connue, la technologie évolue et certains supports seront périmés, donc difficilement lisibles dans quelques années ; par exemple, on constate d’ores et déjà que les ordinateurs portables de dernière génération ne peuvent plus lire directement les cartes CF, Compact Flash, qui étaient la référence il y a peu et qui sont toujours utilisées par des boîtiers de haut de gamme en vente actuellement…).

Il convient donc de transférer régulièrement les photos sur une mémoire de masse (en général disque dur interne ou externe) de l’ordinateur. Pour procéder à cette opération, il existe deux catégories de solutions :

-soit transfert des photos à l’aide d’un cordon liant directement l’ordinateur au boîtier (en général câble USB) ; c’est, apparemment, la plus simple ; le constructeur du boîtier fournit tout : mode d’emploi, logiciels permettant le transfert, la gestion et certains traitements des photos ;

-soit lecture sur l’ordinateur de la carte mémoire, directement si celui-ci comporte un lecteur ad hoc ou par le biais d’un petit lecteur amovible se connectant à l’aide d’un câble USB, puis transfert sur un disque dur ; dans ce dernier cas, il est possible soit de transférer directement les fichiers de la carte mémoire par simple copie, soit d’utiliser un logiciel qui fait cela de manière supposée intelligente, en assurant des fonctions de gestion, voire de traitement.

Personnellement, je n’utilise et ne conseille que le transfert par copie directe pour une raison simple. Tous les logiciels évoluent très vite et il n’est absolument pas garanti qu’ils pourront récupérer et traiter dans cinq ans les photos qu’ils ont prises en compte aujourd’hui. La pérennité de vos photos n’est donc pas totalement assurée par les divers logiciels de gestion de ceux-ci… J’ai déjà personnellement perdu quelques-unes de mes premières photos numériques d’Islande (2001), pourtant sauvegardées, à cause de changements dans les standards de certains supports informatiques (CDRom notamment). J’ai également perdu deux bases de données structurées à l’aide d’un logiciel pourtant très répandu sur le marché : celui-ci est devenu payant et bien trop cher vis-à-vis de l’intérêt des bases en question… A condition d’effectuer les sauvegardes correctement et régulièrement, le transfert par copie simple est donc le plus susceptible d’assurer la pérennité des photos. En outre, il est bien évident que si dans quelques années, après avoir utilisé un boîtier de marque X, vous en achetez un de marque Y, vous n’aurez plus les mêmes logiciels et vous risquez d’aboutir à une situation complexe, sinon insoluble, surtout quand vous changerez en plus d’ordinateur…

Pour réaliser le transfert que je préconise, il faut s’assurer que l’ordinateur possède bien un lecteur pour le type de carte mémoire que le boîtier utilise. Si tel n’est pas le cas, il suffit d’acheter, à peu de frais, un petit lecteur adapté et qui se connecte sur une prise USB de l’ordinateur.

En outre, j’a entendu dire que certains logiciels perfectionnés (trop !) effaceraient d’office les photos de la carte mémoire une fois le transfert réalisé. Ceci est bien sûr extrêmement dangereux et il vaut mieux perdre un tout petit peu de temps à effacer la carte mémoire soi-même uniquement quand on s’est assuré que le transfert a été correctement réalisé (et éventuellement après sauvegarde)

1.2.Stockage et tri des photos

transférées.

Dans la lignée de ce que j’ai écrit précédemment, je n’utilise et ne recommande que la copie pure et simple des photos dans des répertoires de l’ordinateur, sans utiliser de logiciel adapté, qui paraît plus séduisant mais dont la pérennité n’est pas toujours assurée. Avec un PC sous Windows®, le logiciel qui s’impose est l’Explorateur Windows® appelé « Explorer » dans certaines versions (Vista®, ne pas confondre avec Internet Explorer®). Il existe des logiciels similaires sur MAC.

Quand on utilise ce genre de logiciel, ne pas oublier que l’on peut avoir en même temps des imagettes, ce qui aide bien à s’y retrouver. Si elles n’apparaissent pas immédiatement, aller voir du côté de la fonction « Affichage » du logiciel.

Il n’est en général pas utile de conserver des années des photos floues, trop sombres, trop claires, toutes de travers ou pleines de défauts (encore qu’on puisse espérer les redresser ou corriger, voir ci-après…), etc. Il est donc utile de commencer par un tri en passant toutes les photos en revue et en supprimant toutes celles que l’on ne souhaite pas garder. Cela se fait très bien avec les logiciels évoqués ci-dessus, en utilisant ce qu’on appelle la visionneuse. Par contre, il est déconseillé de faire ce tri en cours de séance photo (ou même après), à l’aide de l’affichage sur l’écran LCD du boîtier. En effet, d’une part cela épuise inconsidérément les batteries, et d’autre part, il est très difficile de juger de la qualité d’une photo sur l’écran LCD, du flou en particulier, même en agrandissant l’image. Le meilleur moment pour trier les photos se situe juste après la copie des photos sur l’ordinateur.

Pour ceux qui font beaucoup de photo, il y a là un choix à faire. Quand, comme c’est le cas notamment en photo animalière, on a de longues rafales sur le même sujet, certains préfèrent ne sélectionner qu’une photo et détruire les autres. Personnellement, je préfère garder tout ce qui est raisonnablement correct car l’expérience m’a montré qu’il m’arrive de réutiliser des photos que je n’avais pas jugées comme les meilleures au départ… mais c’est encombrant ! Donc à chacun de choisir.

Il ne faut pas oublier non plus que quand on supprime une photo sur l’ordinateur, on la met dans la « Corbeille » mais qu’elle n’est pas détruite… et continue donc toujours à encombrer le disque dur. Ne pas oublier de vider la « Corbeille » régulièrement !

1.3.Structuration des répertoires

recevant les photos.

Tout dépend du nombre de photos qu’on aura à gérer… et il sera toujours possible de restructurer vers une structure plus complexe quand on aura du mal à dominer le (trop) grand nombre de photos qu’on a réalisées… Donc commencer par une structure simple. Un seul répertoire intitulé « Photo » peut servir pour celui qui démarre. A l’inverse, on peut avoir des structures très complexes quand on a beaucoup de photos à gérer. Ci-dessous la structure d’une petite partie de mes répertoires dans lesquels je stocke mes photos. Je n’y suis arrivé qu’au bout d’un nombre d’années important et elle s’enrichit et évolue en permanence.

Plusieurs précisions :

-beaucoup de rubriques comportent de nombreux sous-répertoires qui ne sont pas présentés ; c’est ainsi que « Photo », « Photos 2009 » et « Photos 2010 » présentent des structures complexes ;

-on notera surtout que j’ai un répertoire variable qui s’appelle actuellement « Déchargement photos 2011», dans lequel je crée un sous-répertoire à chaque séance de photo ; c’est dans ce sous-répertoire que je décharge mes photos brutes avant de les trier, titrer et archiver (voir ci-après) ; une fois ces tâches achevées et les photos en sécurité, je supprime le sous-répertoire correspondant ;

-si l’on veut dater les titres de répertoire comme je le fais dans « Déchargement Photos 2011 », il est recommandé de mettre la date en chiffres sous la forme an,mois,jour, par exemple 20110418 pour le 18 avril 2011 ; c’est la seule solution pour que les répertoires se classent dans l’ordre chronologique.

1.4.Précautions à prendre.

J’ai hérité de mes parents d’une caisse de photos dont certaines remontent au début du XXème siècle. Quel rapport avec la photo numérique me direz-vous ! Il est en fait fondamental. Si vous prenez des photos, en dehors même d’un éventuel côté artistique, c’est que vous voulez fixer sur un support des images fugaces de personnes, de lieux, d’évènements ou autres qui vous ont marqués. J’apprécie ces photos qui m’ont été léguées par les générations précédentes… à condition qu’elles soient dans un état à peu près correct et de savoir un tout petit peu ce qu’elles représentent. Il y a parmi elles de nombreuses photos pour lesquelles j’ignore totalement quels sont les personnages photographiés et plus personne ne pourra me renseigner. Quel intérêt ?

Je signale au passage que scanner ou rephotographier de telles photos puis les améliorer avec les méthodes que j’indique ci-après produit souvent des résultats étonnamment bons.

La photo numérique actuelle n’est pas différente. Si vous faites des photos, c’est certainement que vous avez l’intention de les conserver comme de conserver la mémoire de ce qu’elles représentent. Peut-être pas des siècles mais au moins des années ou des décennies. Le problème est rigoureusement le même et plutôt plus complexe techniquement que pour les photos argentiques sur les tirages desquelles il suffisait d’écrire le sujet et la date. C’est un point d’autant plus crucial qu’une photo numérique ne coûtant rien à prendre, tout le monde a tendance à les multiplier inconsidérément…

1.4.1Titrer les photos.

Il est donc utile de mettre un titre sur toutes les photos que l’on conserve. C’est un travail ingrat ! Mais si vous ne voulez même pas prendre le temps de faire cela, c’est probablement que vous ne prendrez probablement jamais le temps de les regarder non plus... Et puis, il y a des astuces pour aller plus vite, surtout si l’on n’a pas trop l’habitude de taper sur un clavier d’ordinateur…

Je recommande de mettre un nom explicite dans le nom du fichier de chaque photo. Si vous ne donnez un nom qu’à un répertoire, ça peut marcher un moment mais un jour ou l’autre vous aurez dupliqué ou déplacé des photos et vous ne saurez plus d’où elles viennent… Le mieux est de conserver le numéro d’ordre donné par l’appareil photo et de mettre à la suite un petit texte abrégé mais explicite qui indique ce qu’il y a sur la photo.

Par exemple, pour la photo d’un chat pris à Saint-André (Pyrénées-Orientales) en octobre 2009, j’ai remplacé le titre du fichier « IMG_6060 » par « IMG_6060chatStAndréoctobre2009 ». Pour cela, dans l’Explorateur Windows®, j’ai sélectionné le cliché, cliqué à droite puis dans le menu déroulant qui est apparu, sur « Renommer », j’ai positionné le curseur à la fin du titre « IMG_6060 » puis tapé mon texte et fait « Enter ». Une astuce ! Comme j’avais une dizaine de photos de ce charmant animal, pour la première que j’ai renommée, avant de faire « Enter », j’ai sélectionné la partie du texte que je venais de taper : « chatStAndréoctobre2009 » puis fais « Ctrl C » (raccourci de « Copier ». Ensuite, pour tous mes autres chats, au lieu de retaper ce texte un peu long, j’ai fait « Ctrl V » (raccourci de « Coller »).

Il est également possible de titrer les photos en rentrant un titre dans les « données EXIF » (ou « métadonnées » qui est le nom technique correct). C’est plus long, plus compliqué et moins accessible, donc à réserver à des cas très particuliers.

Il existe une solution alternative quand on n’a pas trop de photos à conserver. Elle consiste, après suppression des photos loupées ou qu’on ne souhaite pas garder, à imprimer l’équivalent de ce qu’on appelait des « planches contacts » avec la photo en argentique. Il s’agit de planches comportant un nombre important d’imagettes des photos conservées avec leur nom de fichier et éventuellement d’autres informations (date, etc.). De nombreux logiciels fournis par les constructeurs de boîtiers ou autres sont disponibles pour ce genre d’opération. On peut ainsi caser de 4x8=32 jusqu’à 5x10=50 imagettes par planche. Si l’on prend beaucoup de photos, cela risque cependant de faire beaucoup de papier à classer et gérer. Personnellement, j’avais commencé ainsi mais ai dû renoncer devant le volume peu gérable… mais tout le monde ne fait pas comme moi de la photo animalière avec des rafales de photos qui conduisent à un volume impressionnant de données.

1.4.2.Sauvegarder les photos.

Il y a une chose à faire et une à ne surtout pas faire !

1.4.2.1.Ne jamais travailler sur une photo

originale.

Si vous travaillez une photo pour l’améliorer, c’est qu’elle vous plaît et que vous pensez en faire quelque chose. Un jour ou l’autre, vous aurez progressé ou vous aurez simplement l’idée d’un autre usage de cette photo, donc vous souhaiterez repartir de l’original. Il est donc absolument impératif de ne pas écraser l’original et de sauvegarder la photo travaillée sous un autre nom. Donc dans le logiciel de traitement, ne pas faire « Enregistrer » mais « Enregistrer sous » et changer un peu le nom (par exemple en mettant tout simplement un numéro d’ordre à la suite.

1.4.2.2.Procéder régulièrement à des

sauvegardes.

Le jour où votre disque dur se « plantera » sans crier gare (chose qui se produit beaucoup plus souvent qu’on ne croit !), vous aurez perdu d’un coup toutes vos photos… si vous ne les avez pas copiées ailleurs.

Il est donc essentiel de copier les photos régulièrement sur un autre ou d’autres supports. C’est ce qu’on appelle une copie de sauvegarde. Un disque dur externe est une bonne solution. Utiliser des CDRom ou des DVD peut aussi convenir… mais la pérennité de ce genre de support n’est pas vraiment assurée (voir ci-dessus ce qui est arrivé à quelques-unes de mes premières photos numériques d’Islande). Bon, quand vous aurez tout perdu, il existe toujours des logiciels (parfois gratuits) et des entreprises (pas gratuites du tout) qui sont censés avoir pour tâche de récupérer les données perdues. Ne rêvez pas, ça prend beaucoup de temps pour un résultat aléatoire. (Une astuce peu recommandable mais pouvant servir à d’autres ! Je signale ici que j’ai pu récupérer des photos stockées sur des CDRom et devenues totalement illisibles sur mes ordinateurs actuels… en réactivant mon vieil ordinateur de 2001 sous Windows 98SE® et son vieux lecteur de CD qui avait créé les CDRom en question, puis en transférant les données redécouvertes sur une clé USB. Seul un fichier d’une photo est resté rétif… mais comme je l’avais à la fois en format .bmp et .jpg, je n’ai rien perdu…).

En un mot, aucun support n’est sûr et il n’y a aucune garantie de pérennité des supports dans le temps. Il est donc absolument essentiel d’avoir au moins deux exemplaires des fichiers auxquels on tient et de relire les deux de temps à autre. Sinon, c’est le jour où le support principal flanchera pour une raison quelconque qu’on s’apercevra que l’autre n’était déjà plus lisible. Ceci reste vrai même avec des formats et des supports qui paraissent aussi fiables que le jpeg et les CDRom. Quant aux fichiers auxquels on ne tient pas… pourquoi les garder ?

La « vrai sauvegarde

professionnelle » utilise deux disques durs. En effet, il s’agit alors

d’écraser les données du disque de sauvegarde avec celles, à jour, du disque de

l’ordinateur. Un « plantage » en cours de sauvegarde peut donc

détruire à la fois les données de l’ordinateur et celles du disque de

sauvegarde. On sauvegarde donc alternativement sur l’un ou l’autre des deux

disques durs de façon à conserver toujours la sauvegarde la plus récente.

Il existe également

des sauvegardes avec des « disques miroirs », l’information étant

conservée en permanence sur deux disques ayant le même contenu et qui sont donc

censés ne pas tomber en panne simultanément (« censés » car s’il y a un incendie par exemple, c’est une autre

histoire… D’où l’utilisation de sauvegardes déportées, c’est-à-dire stockées en

d’autres lieux… ce qui peut par ailleurs poser le problème de la sécurité des

données confidentielles. Etc. ). Bien entendu, chaque amélioration bien

réfléchie est utile mais complique souvent le travail et crée de nouvelles

failles dans le système... Avant toute solution complexe, il faut donc d’abord

savoir vis-à-vis de quoi on veut se prémunir, panne matérielle, destruction

globale comme un incendie, piratage, sabotage, etc. et les solutions vis-à-vis

de ces divers risques sont souvent contradictoires ; par exemple,

multiplier les copies préserve des pannes matérielles mais facilite le

piratage.

On s’éloigne ici de

notre modeste photo numérique d’amateur et je n’irai donc pas plus loin. Avoir

des copies de sauvegarde régulières sur un autre disque dur est déjà une bonne

sécurité qui suffit à la plupart des photographes !

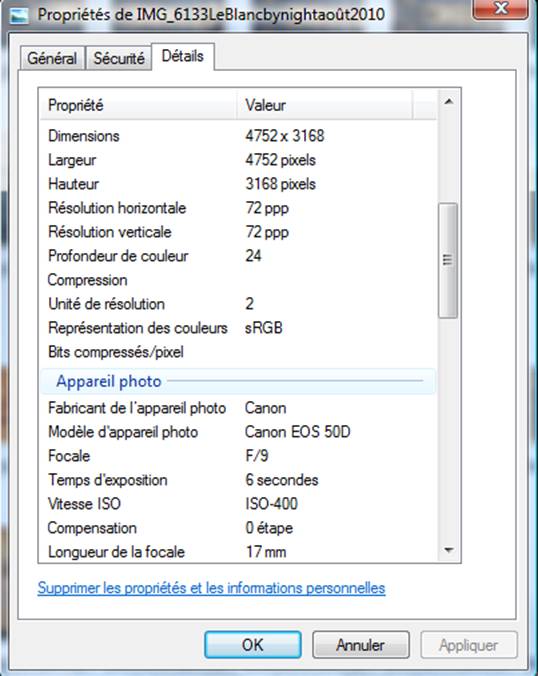

1.4.2.3.Les fichiers

originaux contiennent des données que l’on nomme « métadonnées » ou

« données EXIF » qui indiquent tous les éléments de prise de vue,

vitesse, sensibilité, boîtier, etc. ; il est important de conserver

celles-ci, donc de vérifier que leur transfert initial se fait bien ; sous

l’Explorateur Windows® (baptisé « Explorer » dans Vista®), il suffit

de pointer le fichier, de cliquer à droite et d’aller dans Propriétés/Détails

pour les trouver ; ces données permettent de savoir quels paramètres de

prise de vue on a utilisés à un moment donné, soit pour pouvoir recommencer

lors d’une nouvelle prise de vues quelque chose qu’on trouvait bien, soit au

contraire pour ne pas recommencer deux fois une même erreur… (attention, dans

l’exemple ci-dessous, mon logiciel Photoshop® a un bug : au niveau de la

valeur de l’ « Ouverture », il est marqué « Focale »,

ce qui est évidemment erroné…)

Quand on fait des traitements et même

parfois des copies (par exemple en utilisant « Enregistrer sous »

avec certains logiciels), il arrive que ces données soient détruites; par

exemple, mon vieux Photoshop® les détruit même si je n’ai fait qu’un petit traitement

sur la luminosité alors que GIMP2® ne les détruit pas. Il est important de savoir ce qu’il en est réellement et d’essayer de

les préserver autant que faire se peut.

1.4.3. Achever le travail en effaçant les

données de la carte mémoire et en vidant la corbeille de l’ordinateur.

Il est bien évident que si vous avez transféré les données à partir du boîtier, ça n’est pas pour continuer à encombrer celui-ci et ses cartes mémoires. L’effacement se fait grâce à une fonction du boîtier à trouver dans la notice de celui-ci. En principe, cela peut se faire également à partir de l’ordinateur mais peut être très dangereux dans certains cas pour la carte mémoire.

De même, si vous ne videz pas la « Corbeille » de l’ordinateur de temps à autre, le disque dur de ce dernier reste aussi encombré que si vous n’aviez pas supprimé les photos mises à la corbeille.

1.5.En résumé.

Une bonne séquence pour le déchargement des

photos peut être :

-décharger les photos en les stockant dans

un répertoire ad hoc ;

-faire le tri et supprimer tout ce qui ne

mérite pas d’être gardé, renommer les autres en conservant le numéro donné par

le boîtier ;

-effacer la carte

mémoire ;

-vider la

« Corbeille » de l’ordinateur de temps à autre ;

-sauvegarder de temps

à autre les photos que l’on a stockées (traitées et non traitées) ;

-quand on traite une

photo, la sauvegarder sous un nom différent de façon à préserver l’original.

Ca peut paraître un peu lourd mais on s’y retrouve largement au bout de quelques années quand on a des photos dans tous les coins et de tous les coins…

2.Qu’est-ce

qu’une photo numérique ?

2.1.Description.

La présentation ci-dessous est la description de ce qu’est une image quand elle est arrivée dans le logiciel de traitement qui va s’occuper d’elle. Elle ne correspond pas à ce qui est dans le boîtier, qui est beaucoup plus compliqué et elle a déjà subi des traitements complexes qui faussent le contenu informatif (par exemple, le dématriçage crée une quantité importante d’information qui n’existait pas lors de la prise de vue, il s’agit bien entendu là d’une énormité en termes de traitement de l’information mais tous les boîtiers dotés d’une matrice de Bayer en sont réduits là et c’est l’immense majorité, voire la totalité, des matériels disponibles sur le marché au moment où j’écris… ; je développerai par ailleurs dans un autre texte ces aspects du prétraitement des prises de vues par le boîtier et ce qui concerne le RAW et le jpeg).

Une image peut se représenter comme une répartition régulière de carrés élémentaires dans un rectangle qui est l’image entière. Ces carrés sont appelés « pixels », de l’anglais Picture element. Par exemple, les images fournies par mon boîtier actuel comportent 4752x3158 pixels soit 15.006.816 pixels, nombre que l’on arrondit pour dire « 15 millions de pixels » ou encore « 15 méga-pixels ». Dans l’ordinateur, avec mes images transmises en jpeg, chaque pixel se voit attribué 3 valeurs correspondant aux trois couleurs fondamentales, le bleu, le vert et le rouge. Chacune de ces valeurs est codée sur un octet, soit 256 valeurs de 0 à 255.

Ces trois valeurs combinées et restituées sur l’écran de l’ordinateur ou, en fin de traitement, sur l’imprimante, correspondent à une nuance de couleur. Voici par exemple ci-dessous un exemple d’un tout petit morceau d’une image numérique :

Chaque carré correspond à un pixel. Sa couleur étant codée sur 3x256 valeurs, il peut y avoir 2563 couleurs ce qui correspond à plus de 16 millions de valeurs différentes. La valeur codée par 3 zéros correspond au noir pur et celle codée 3 fois 255 au blanc pur. On notera au passage qu’il est admis que l’œil humain peut séparer normalement 15.000 nuances. Cela fait mille fois moins que les possibilités évoquées ci-dessus et donc bien moins que ce qu’est censé nous présenter notre écran ou notre imprimante, pour autant qu’ils aient eux-mêmes des caractéristiques techniques leur permettant de séparer celles-ci.[1] A l’inverse, on remarquera au passage que les 15.000 nuances que notre œil peut séparer pourraient se coder sur 9 bits alors que le jpeg utilisé en photo numérique code sur 3x8=24 bits et le RAW « décrypté dans l’ordinateur » en principe sur 3x14=42 bits. Si l’usage du RAW est intéressant pour obtenir de « belles photos », ça n’est en tout cas pas parce qu’il peut séparer plus de nuances.

Le RAW et le jpeg seront examinés par

ailleurs mais il faut déjà préciser que le RAW actuel (juin 2011) n’a rien de « RAW »

car il n’est pas du tout une représentation brute de ce qui est mesuré par le

capteur du boîtier. Il a existé des « RAW » véritables (ou presque)

avec les images des satellites d’observation de la Terre et il va peut-être y

en avoir de nouveau avec les boîtiers SIGMA® dotés de capteurs FOVEON. Il n’y

en a en aucun cas avec les actuels boîtiers du commerce dotés d’une matrice de

BAYER car cela ne présenterait aucun intérêt avec un tel capteur.

2.2.Les bêtes noires du photographe

numérique. Bruit, effets de bord, balance des blancs.

2.2.1.Bruit.

Le bruit est matérialisé par un aspect moucheté de la photo, au moins dans certaines zones. Par définition, le bruit est quelque chose qu’on ne peut pas modéliser et qu’on ne peut connaître que de façon statistique. Il n’y a donc pas de logiciel ou de technique miracle qui puisse éviter le bruit, contrairement à ce qu’on pourrait croire en lisant les notices de certains constructeurs. Bien entendu, il faut essayer de se placer dans des conditions de prise de vue qui évitent autant que possible d’avoir du bruit (voir à ce sujet ce que j’ai écrit par ailleurs sur les conditions de prise de vue). Mais le problème de nombreux traitements est qu’en améliorant la photo, ils « améliorent » donc renforcent aussi le bruit. C’est l’une des raisons pour lesquelles j’indique un ordre dans les traitements : celui-ci vise à limiter l’apparition du bruit ou à choisir des paramètres qui le minimisent.

Nous verrons au fil des traitements ce qu’il y a lieu de faire pour lutter contre son apparition, voire pour le supprimer, car s’il n’existe pas de processus physique absolu qui puisse l’éliminer, il existe des techniques qui permettent de le faire disparaître en partie ou en totalité dans les zones où il est gênant.

2.2.2.Bruit dans les images argentiques

scannées.

La numérisation de certaines photos argentiques conduit parfois à des images extrêmement bruitées. Ceci se comprend très bien avec un tout petit peu de théorie et l’on pourra se reporter à la partie en italique à ce sujet. Disons qu’au niveau élémentaire, ce bruit provient du fait qu’on a scanné la photo argentique (négatif ou diapo, peu importe) à un pas trop fin vis-à-vis de la sensibilité de la pellicule qui avait été employée. En un mot, on peut se permettre un pas plus fin avec des photos prises en 50 ISO qu’en 400 ISO. Mieux vaut donc renumériser la photo avec un pas plus grossier que se battre avec des problèmes de bruit sans fin… dont on ne viendrait très probablement pas à bout. On pourra toujours dire qu’on perd ainsi en résolution… mais c’était bien le choix initial du photographe car les pellicules argentiques perdaient en finesse avec l’augmentation de la sensibilité (« grain » de la photo plus gros).

2.2.3.Les effets de bord.

Les effets de bord ne sont pas une propriété intrinsèque de la photo. Ils n’apparaissent que lors de traitements inadéquates. Il faut cependant en être bien conscient pour les éviter et les traquer dès qu’ils apparaissent. Il y a au moins deux causes qui peuvent générer des effets de bord :

-le traitement trop brutal d’un sujet aux limites bien tranchées ; c’est par exemple le cas avec des renforcements de netteté intempestifs ;

-le travail sur des calques qui ont détouré un élément de la photo ; si l’on n’y prend pas garde, des horreurs peuvent parfois apparaître sur les bords de la zone délimitée par le calque lorsqu’on colle le calque travaillé sur la photo.

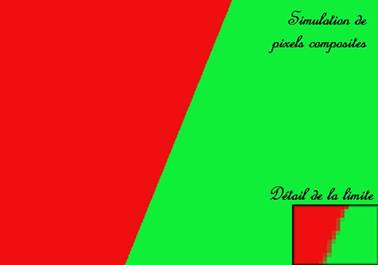

Ci-après, un exemple d’effet de bord créé par un renforcement de netteté beaucoup trop violent. On notera au passage qu’un bruit devient également visible alors que l’image était en fait fort peu bruitée.

2.2.4.La balance des blancs.

Des dominantes colorées peuvent apparaître sur la photo si le réglage de la balance des blancs sur le boîtier n’est pas en concordance avec l’éclairage de la scène photographiée. Il peut s’agir d’une erreur ou d’un choix. Toujours est-il que si cette dominante n’a pas un résultat esthétique volontaire… ou involontaire, il faut y remédier. Nous verrons dans la suite comment.

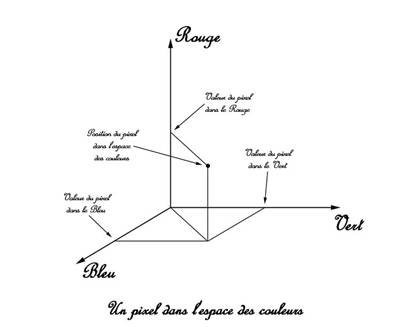

L’espace

des couleurs ou espace des radiométries.

Chaque pixel d’une

photo numérique peut donc être représenté par un point dans un espace à trois

dimensions, chacun des axes correspondant à une des couleurs fondamentales. La

photo en entier va alors être représentée par un nuage de points dans cet espace

que je nommerai dans la suite espace des

couleurs. Je souligne au passage que si vous avez, comme moi, la curiosité

de rechercher « espace des couleurs » sur Internet, vous trouverez

surtout « espace couleur » ou « espace colorimétrique »

avec d’innombrables développements complexes sur la colorimétrie, le gamma, le

gamute et bien d’autres. L’espace auquel je fais référence est celui qui a été

utilisé en traitement d’images sous le nom d’ « espace des

radiométries » par les spécialistes du traitement des images

spatiales ou aériennes numériques, discipline qui s’est développée à partir du

lancement du premier satellite d’observation de la Terre en 1972 (il n’y a pas vraiment de différence avec

celui de la colorimétrie, sauf que la présentation de ce dernier fait souvent

des raccourcis impressionnants qui la rende peu compréhensible par le profane).

En photographie numérique, il y a tellement de traitements plus ou moins cachés

entre la mesure radiométrique faite par le capteur de l’appareil et l’image telle

qu’elle arrive dans l’ordinateur que je n’ose employer le mot

« radiométrie ». Je m’en tiens donc au vocable « espace des couleurs ». Je précise

que je ne parlerai pas ici des notions abordées par la colorimétrie, au premier

rang desquelles celle de gamma, car cela n’apporterait absolument rien aux

développements que je vais faire. Par contre, assimiler les développements que

je fais devrait aider grandement à la compréhension des notions de gamma,

d’espace colorimétrique ou de ce qui se

passe avec le RAW et le jpeg pour ceux qui ne l’ont pas déjà compris par

ailleurs. Je compte bien aborder toutes ces notions dans d’autres parties du

document dont ceci n’est qu’une petite partie… mais ne mélangeons pas les

genres ! Toutes ces notions sont

simples si on les aborde une par une et dans l’ordre, sans les mélanger.

Elles deviennent par contre affreusement compliquées quand on veut les

appréhender toutes à la fois.

L’espace des couleurs

dont je parle est donc strictement l’espace des pixels de la photo telle

qu’elle est prise en compte par l’ordinateur pour subir les traitements d’image

qui vont nous permettre de l’améliorer. Ce mode de représentation est absolument

essentiel pour appréhender ce que font les traitements que nous allons examiner

dans la suite. Je pense que nous verrons clairement que la foule des

photographes numériques qui traitent des photos passe une partie importante de

son temps à travailler dans l’espace des couleurs sans le savoir, comme Mr

Jourdain faisait de la prose…

Schéma représentant un pixel dans l’espace des couleurs :

J’ai reporté ici les

axes dans l’ordre dans lequel je les pratiquais dans les années 1980. Il s’agit

en fait de l’ordre des longueurs d’onde croissantes car pour les premiers

satellites d’observation de la Terre, on avait plutôt des longueurs d’onde

correspondant au vert, au rouge et à l’infrarouge proche (à cause de la

diffusion atmosphérique particulièrement forte dans le bleu). J’ai constaté sur

Internet que certains prennent un ordre différent. Le tout est de le savoir et

de ne pas tout mélanger ![2]

Toute la photo est donc représentée par un nuage de points dans cet

espace. Il faut cependant garder à l’esprit que les valeurs dans les trois

couleurs vont de 0 à 255 (codage sur un octet) par valeurs entières. On peut

aussi dire que dans cet espace, toute la photo tient dans un cube de 255 unités

de côté (256 valeurs possibles), limites de celui-ci incluses. En mathématique,

on parle d’une « représentation discrète ».

Pour essayer de

concrétiser un peu avec une notion que nous ne devrons jamais perdre de vue

dans la suite, un pixel totalement blanc aura comme valeurs dans les trois

couleurs 255,255,255 et sera au sommet du cube opposé à l’origine, alors qu’un

pixel totalement noir aura pour valeurs 0,0,0 et sera à l’origine des axes.

Tout ce que j’appelle

dans la suite « traitements dans l’espace des couleurs » consiste

donc à déplacer en bloc le nuage de point, à le triturer dans tous les sens,

afin que la photo qui lui correspond soit la plus plaisante possible. J’y

reviendrai mais on comprend tout de suite que si l’on fait subir au nuage des

traitements qui vont essayer de lui faire dépasser les limites du cube en

question, on amènera ainsi des pixels vers les sommets de celui-ci,

c’est-à-dire qu’on créera des pixels blancs purs ou noirs purs, c’est-à-dire qu’apparaîtront

dans la photo des zones complètement saturées en blanc (« cramées »)

ou en noir. Ce n’est en général pas ce qu’on recherche !

On comprend également

que pour travailler sur ce nuage de points, on va utiliser diverses fonctions

qui font des calculs sur les trois valeurs qui définissent les pixels. Comme on

ne travaille que par valeurs entières, on

aura automatiquement des arrondis à la valeur la plus proche. Lorsqu’on multiplie les traitements, on

multiplie aussi les arrondis et on risque à la longue de dégrader l’image.

C’est une raison pour bien choisir ses traitements de façon à obtenir le

résultat recherché en un minimum d’opérations. C’est d’autant plus vrai que

de toute façon, on travaille toujours sur le même nuage de points avec des

fonctions qui paraissent différentes mais ont toutes un peu la même

philosophie. On est un peu en train de « malaxer un chewing-gum à

l’intérieur d’un cube ». On peut toujours malaxer deux heures, on aura

toujours le même chewing-gum mais il sera de plus en plus informe, si l’on me

permet cette image tout à fait réaliste mais peu digne d’un document sur cette

discipline très sérieuse qu’est le traitement d’images…

Pixels composites.

La notion de

« pixel composite » est essentielle pour comprendre assez facilement

ce qui se passe dans de nombreux cas de traitement, soit en bien si on les gère

bien, soit en mal si on ne leur prête pas assez d’attention. Cela ne me

dispensera pas de donner en outre un autre niveau d’explication mathématique

faisant appel à des théories comme celle des distributions, mais devrait

permettre au plus grand nombre de lecteurs d’entrer un peu plus dans les

détails.

Imaginons que nous

voulons photographier un sujet qui serait une simple feuille de papier séparée

en deux zones de couleurs différentes. Les pixels qui concernent uniquement une

des plages auront des valeurs toutes les mêmes (en supposant le capteur

photographique parfait… ça n’est pas le sujet ici d’imaginer autre chose). Par

contre, sur la limite, des pixels auront une valeur intermédiaire parce qu’ils

concernent un peu de chacune des deux zones, ce sont des « pixels

composites ». On comprend bien dès maintenant que l’aspect de la photo au

cours des traitements changera suivant qu’on préserve une limite étroite avec

peu de pixels composites ou au contraire qu’on étale ceux-ci de part et d’autre

de la limite. Il n’y a pas de vérité

mathématique absolu : suivant la photo, on pourra préférer avoir une photo

plus lissée avec beaucoup de pixels composites ou au contraire plus dure avec

des limites nettes. Ci-dessous, une simulation des pixels composites

tels qu’ils pourraient apparaître en photographiant une feuille de papier

séparée en deux parties rouge et verte.

L’espace géométrique.

C’est tout simplement

celui dans lequel nous voyons la photo. Il a deux dimensions, chaque pixel a

deux coordonnées que l’on note bien évidemment X et Y si l’on éprouve le besoin

de les désigner. Ces coordonnées prennent des valeurs discrètes (au sens

mathématique de ce terme, elles ne peuvent pas prendre toutes les valeurs mais

simplement des valeurs multiples de celle de la taille d’un pixel.

On aura bien entendu à travailler dans cet espace pour modifier la

géométrie de la photo.

On verra dans la suite

que d’autres traitements travaillent à la fois dans les deux espaces (ou si

l’on veut, dans l’espace à 5 dimensions qui serait nécessaire pour décrire

toute l’information de la photo, mais on n’utilise guère cette notion trop

abstraite pour l’esprit humain : si l’on voit clairement un espace à deux

dimensions, qu’on appréhende bien un espace à trois dimensions car nous vivons

dans un tel espace, ce n’est plus le cas pour un espace à cinq dimensions).

Le bruit.

Le bruit apparaît sous

forme de pixels ou groupes de pixels de couleurs variées là où l’on devrait

avoir une plage uniforme. Voir illustration. Il a au moins deux sources

possibles: d’une part la diffusion de la lumière par l’atmosphère et les sujets

photographiés et d’autre part l’électronique de prise de vues. La première

cause de bruit est d’autant plus gênante que l’on a moins de lumière qui arrive

sur le capteur photographique. Il ne faut pas perdre de vue qu’on aura moins de

lumière si l’on prend une photo dans des conditions d’éclairage déficientes…

mais aussi si la vitesse d’obturation est très rapide, ce qui ne laisse pas

arriver beaucoup de photons jusqu’au capteur. De toute façon, avec les boîtiers

modernes, on peut considérer que c’est la première cause de bruit qui est

largement prépondérante quand une photo apparaît bruitée. Je ne parlerai donc

que de lui (…et les méthodes visant à réduire ou à supprimer le bruit ne se

préoccupent de toute façon pas de son origine ; par contre, il est

essentiel de se préoccuper de son origine pour tenter de l’éviter lors de la

prise de vue).

La diffusion

atmosphérique produit du bruit dû à la diffusion de la lumière par les atomes

qui composent l’atmosphère. Sans rentrer dans des considérations de physique

quantique qui apporteraient peu, on peut dire que si ce phénomène ne se

produisait pas, le ciel serait noir au lieu d’être bleu, comme ont pu le

constater les astronautes qui ont été sur la lune, dépourvue d’atmosphère. De

même, si vous prenez une photo sans flash dans une pièce peu éclairée,

intérieur de château ou d’église par exemple, la lumière qui vous éclaire provient à la fois

de la diffusion par l’atmosphère du lieu mais aussi et surtout des réflexions

multiples sur les murs et objets environnants de la lumière qui arrive de

l’extérieur par les rares fenêtres. C’est du reste abusivement que j’emploie le

terme « réflexions », en toute rigueur, il faut parler de

« rétrodiffusion », les murs ne se comportant pas comme des miroirs,

et il faut aussi parler de l’absorption d’une partie de la lumière par ces

éléments, ce qui peut créer également des biais sur les couleurs reçues par le

capteur.

Mais surtout, il arrive peu de photons sur

chaque élément du capteur photographique (particules de lumière quand on

considère la lumière sous sa présentation corpusculaire et non ondulatoire).

Ces photons ayant interagit avec beaucoup de choses, molécules de l’atmosphère,

murs ou objets et arrivant en petit nombre et « en vrac » sur le

capteur, on aura statistiquement une dérive variable au niveau de chaque pixel

du capteur. En effet, s’il n’arrive que quelques photons sur un capteur, il n’y

a statistiquement qu’une faible probabilité qu’ils arrivent dans les

proportions dans lesquels ils sont pour composer une lumière blanche de forte intensité.

D’où des points de couleur variée sur la photo, chaque pixel ayant reçu une

proportion différente de photons de chaque couleur (correspondant à la longueur

d’onde de chaque couleur). J’aborderai ce point à propos du RAW et du jpeg mais

avec les boîtiers actuels dotés d’un matrice de Bayer, le

« dématriçage » que réalise le boîtier avant de délivrer la photo

n’arrange certainement pas les choses.

Il est important de

comprendre cela car cela influe fortement sur le bruitage, ou non, des prises

de vues et aussi sur la correction de ce défaut. C’est ainsi que, si vous

utilisez une sensibilité très élevée, par exemple 2000ISO, en intérieur

sans flash, vous avez toutes les chances d’obtenir une photo très bruitée. Ca

n’est pas une raison pour ne pas essayer si vous n’avez pas d’autre solution… Par

contre, en extérieur, avec une lumière solaire vive, l’essentiel de la lumière

qui parvient au capteur de votre boîtier provenant de l’éclairage direct du

sujet par le soleil, le bruit sera proportionnellement beaucoup plus faible. Or

contrairement à ce qui vient immédiatement à l’esprit, il peut être très utile

de recourir à de très fortes sensibilités en plein soleil, notamment pour des

sujets qui se déplacent très vite, véhicules en mouvement, photos de sport,

animaux en mouvement.

On peut ainsi avoir

des résultats étonnants. Par exemple, quand on prend un oiseau en vol sur fond

de ciel avec une grande vitesse et une forte sensibilité, l’oiseau lui-même

pourra être très peu bruité alors que, paradoxalement, le ciel bleu le sera

beaucoup plus à cause de la diffusion atmosphérique. Cela a des implications

sur des modes de correction du bruit que j’expliquerai plus loin.

Je donne

l’interprétation que je fais de ce dernier point pour ce qu’elle vaut :

elle ne pourrait être validée que par des calculs de physique statistique que

je n’ai pas faits. En outre, il n’y a pas de doute que l’œil peut être plus

sensible au bruit sur une grande surface à peu près unie comme le ciel que sur

le sujet lui-même (encore que ce dernier étant en général plus foncé, le bruit

devrait au contraire ressortir). Ce qui est sûr, c’est que ça marche dans

certains cas et que visuellement, on arrive souvent à la situation que j’évoque

ci-dessus.

Cas de photos argentiques scannées.

Qu’il s’agisse de

négatifs ou de diapositives ne change rien à la problématique. Une photo

argentique en couleur est composée de trois couches sensibles aux trois

couleurs mais au lieu d’un découpage en pixels carrés (grossière approximation

du numérique…), on a affaire à des grains répartis de manière aléatoire. Le

scannage conduit quand à lui à des pixels carrés codés dans les trois couleurs.

Il est bien évident que si la taille des pixels est petite par rapport à celle

des grains de la photo initiale, chaque pixel ne va prendre de manière

aléatoire qu’une information partielle sur les trois couleurs correspondantes

suivant qu’il « tombe » sur un ou plusieurs grains d’une ou plusieurs

couleurs. On obtiendra donc une image avec des pixels aux valeurs variables et

aléatoires qui pourront donner une impression de bonne photo si l’on regarde la

globalité du résultat mais qui va conduire à une mosaïque affreuse de pixels de

couleurs variées quand on plonge dans le détail… On fait un peu du Seurat…

Il est bien évident

que le meilleur remède est de prendre un pas de numérisation plus grand… ce qui

veut simplement dire de ne pas faire donner par la photo initiale plus

d’information qu’elle n’en contenait. La mesure par le scanneur sur un pixel

réalise alors l’intégration (au sens mathématique du terme) des valeurs dans

les trois couleurs sur les grains qui tombent en totalité ou en partie dans le

pixel en question. Il n’y a pas de formule miracle : le pas à choisir

étant fonction de plusieurs paramètres dont le grain de la pellicule argentique

qui a été utilisée, valeur dont on n’a pas connaissance, el mieux est de

procéder par essais et erreurs jusqu’à avoir trouvé un pas qui convient.

Si l’on dispose d’une

photo numérisée et bruitée à cause d’un pas de numérisation trop petit sans

avoir de quoi la reprendre, la situation est presque désespérée ! On peut

néanmoins imaginer des traitements qui essayeront de sauver la situation. Cela

va de celui que j’aborderai dans la suite, avec peu d’espoir dans ce cas,

jusqu’à des filtres passe-bas ou des algorithmes analogues à ceux utilisés par

le boîtier numérique dans le dématriçage des résultats fournis par la matrice

de Bayer du capteur. Sur les filtres passe-bas, on se reportera au chapitre 7.

ci-après. D’après le peu que j’ai pu en voir, les scannages faits dans le

commerce, ayant été mis au point par des professionnels, évitent cet

inconvénient, c’est la moindre des choses.

Le problème est tout

autre si les photos à numériser se sont « piquées » avec le temps (par

exemple dans mon cas, petits points de poussière ou plus probablement de moisi

sur des diapositives prises il y a longtemps en pays tropical). L’aspect est

très différent et s’apparente, en pire, aux taches de capteur des réflex

numériques. En pire car les taches plus petites sont aussi beaucoup plus

nombreuses. Si l’on tient vraiment à la photo, il n’y a plus qu’à

« retrousser ses manches » et faire des retouches comme je les décris

au chapitre 6. Dans les cas les plus favorables, on peut espérer s’en sortir

avec certaines fonctions comme « Anti-parasites » de GIMP2®, avec un

risque non négligeable de dégradation de l’image.

Les effets de bord.

Les effets de bord

viennent essentiellement de la mauvaise gestion des pixels composites ou de la

création intempestive de pixels composites par des processus inadéquates. Ils

peuvent également se produire quand on sélectionne une zone et qu’on utilise

ensuite une fonction de calcul qui recalcule les valeurs des pixels à partir de

ceux qui environnent celui-ci. On conçoit

en effet qu’arrivé sur les bords, l’algorithme qui recalcule les valeurs

affectées au pixel n’a plus d’éléments sur les pixels suivants qui sont hors

champ. Tout dépend alors à la fois de la manière dont l’algorithme a été conçu

et de ce qu’on trouvera ensuite dans la photo au-delà de la limite de la

sélection. A noter que certaines fonctions de certains logiciels, GIMP2® par

exemple, permettent justement un choix entre plusieurs modes de calcul des

pixels de bord

3.Première

phase de traitement de la photo : recadrage, redressement, balance des

blancs.

Il ne faut jamais perdre de vue qu’une bonne photo, c’est normalement celle qui sort du boîtier avec déjà le bon cadrage, la bonne luminosité, la bonne netteté et sur laquelle il n’y a rien à faire que cliquer sur la commande « Impression ». On aura en général une photo d’autant plus satisfaisante que le cliché original sera proche de ce que l’on veut obtenir et les traitements à faire plus légers… Mais puisqu’il existe des traitements, abordons-les donc.

La première opération de traitement d’une photo est de regarder son aspect général et de se faire une idée de ce qu’on veut en faire. Une des premières questions qui vient à l’esprit est de regarder si elle ne présente pas des défauts colorimétriques évidents et de l’organiser dans l’espace. Il y a (au minimum…) trois questions à se poser :

La photo est-elle droite ou faut-il la redresser ? (il est particulièrement désagréable d’avoir une ligne d’horizon oblique ou des verticales qui partent d’un côté, sauf recherche d’un effet particulier, ce qui est une autre histoire).

La

balance des blancs est-elle correcte… ou, en termes moins techniques, n’y a-t-il pas des dominantes de couleurs

intempestives ?

Quel cadrage serait plaisant pour cette photo ?

La première phase de traitement va en découler. Le meilleur ordre pour ces opérations est : redressement de la photo si nécessaire, puis recadrage et enfin balance des blancs si nécessaire. Pour la majorité des clichés, il ne devrait y avoir que la seule opération de recadrage. Avoir à procéder à l’une des deux autres ou aux deux augure mal de la qualité de la photo… Par contre, si l’on veut imprimer, le recadrage s’impose pratiquement tout le temps, le format des images n’étant en général pas proportionnel à la taille des papiers pour l’imprimante (sauf si l’on accepte une marge blanche variable sur le tirage…).

Je souligne qu’en bonne théorie du

traitement d’images, il ne faudrait pas commencer par ces traitements qui vont

commencer à dégrader, légèrement mais prématurément, l’image. Seulement, on ne

fait pas ici de la théorie mais de la photo ! Si l’on n’a pas corrigé les

défauts en question et fait le cadrage préalablement, ça n’est pas sérieux de

vouloir aller plus loin dans l’amélioration d’un cliché car on n’appréhenderait

pas correctement sa globalité.

3.1.Redressement du cliché.

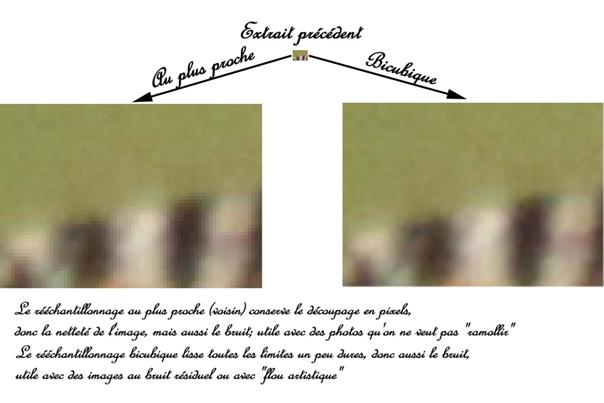

Il suffit de procéder à une rotation paramétrée en donnant un angle de rotation adapté. Le plus simple est d’estimer un premier angle, d’appliquer la rotation et de voir ce que ça donne. On en déduit une valeur affinée de l’angle à donner à la rotation. On annule alors la rotation précédente puis on applique une rotation avec le nouvel angle… et ainsi de suite jusqu’à obtenir un cliché correctement redressé. Il est souhaitable de disposer d’un logiciel qui autorise le rééchantillonnage « au plus proche voisin ». Par exemple GIMP2 le propose dans les paramètres de la rotation sous le nom « Outils/Outils de transformation/Rotation » puis « Type d’interpolation : Aucune »… S’il est disponible, il est absolument essentiel de remplir ce paramètre correctement et de ne surtout pas laisser le « cubique » (ou « bicubique ») qui est souvent le paramètre prédéterminé. Si l’on ne dispose pas d’un tel paramètre, la rotation est une opération qui dégrade fortement le cliché dans la mesure où les paramètres de « rééchantillonnage » ne sont pas maîtrisés (le rééchantillonnage est le calcul pixel par pixel des valeurs attribuées aux différents pixels de l’image transformée à partir de l’image initiale). Empiler des rotations revient alors à empiler des dégradations successives, Pour la question des « rééchantillonnages », j’explique les tenants et aboutissants au chapitre 8. dans la remise au format de l’image.

A noter que certains logiciels, certaines versions de Photoshop® notamment, permettent à la fois de recadrer et d’effectuer la rotation en une seule fois sans avoir à donner une valeur chiffrée à l’angle mais « d’un coup de souris ». Cela n’enlève absolument rien au problème du rééchantillonnage mais peut toujours éviter les tâtonnements et les opérations multiples.

3.2.Recadrage du cliché.

Cela fait partie de la partie « artistique » du travail du photographe et non du côté technique. Néanmoins, il y a quelques petites contraintes techniques :

-le mieux est de sélectionner la zone à conserver après recadrage puis d’utiliser la fonction recadrage ; ne pas créer de calque par copier/coller et s’assurer que le logiciel n’en crée pas automatiquement ; si des calques venaient à être créés à ce stade, les fusionner immédiatement car ils ne peuvent que nuire au reste du traitement en le compliquant ou le perturbant ;

-un paramètre doit être respecté, c’est le rapport hauteur/largeur qui doit correspondre à la surface que l’on veut imprimer ;

-il tombe sous le sens qu’on n’a en général pas intérêt à garder des zones toutes blanches (« cramées ») ou toutes noires… mais à condition qu’elles soient effectivement toutes blanches ou toutes noires et donc irrécupérables ; s’il y a des nuances qui n’apparaissent pas visuellement mais qui existent, un des grands rôles du traitement qui va suivre sera d’essayer de les sauver ; pour s’en assurer, on peut par exemple regarder l’histogramme de l’image et voir s’il y a des valeurs à 255 ou à 0, ou encore procéder avec la pipette en pointant sur plusieurs points des zones en question, ou mieux en appliquant à titre de test la fonction « Luminosité/Contraste » avec excès, juste pour voir et bien entendu sans conserver le résultat ; la fonction « Courbes » est encore meilleure mais demande plus de doigté ; je ne m’étends pas plus là-dessus car tout cela fera l’objet d’une présentation détaillé dans le chapitre 4.; à noter que, quand on est un peu expérimenté, on peut très bien procéder aux traitements qui récupèrent ces zones avant de faire le recadrage, ce qui apporte un certain confort supplémentaire dans le choix de celui-ci ; voir au chapitre suivant ;

-à ce stade, il est fortement déconseillé de mettre l’image à la taille d’impression par une fonction du genre « Taille de l’image » ou « Taille d’impression » ou autre ; en effet, certains paramétrages de ces fonctions dégradent fortement et prématurément l’image alors qu’on peut au contraire jouer sur eux pour peaufiner le traitement à la fin de celui-ci (voir le chapitre 8. à ce sujet).

3.3.Correction d’une mauvaise balance

des blancs.

Un défaut dans la balance des blancs apparaît sous forme de dominantes colorées. Le traitement qui correspond fait partie de ceux qui seront abordés au chapitre 4. Cependant, comme il s’agit d’un traitement de « récupération », il est plus à sa place ici. A noter également que, dans une certaine mesure, il permet de ne pas s’occuper du paramètre « Balance des blancs » sur le boîtier et de corriger sur l’image. Cela peut présenter plusieurs avantages :

-conserver un éclairage un peu amusant pour tester ce que ça donne ;

-ne pas mettre de balance des blancs sur le boîtier dans des cas où cela n’est pas possible pratiquement (un exemple que je pratique : macrophotos de minéraux sur statif en éclairage artificiel avec très forts grossissements, pour des tirages papier x40 à x100…) ;

-éviter d’oublier de remettre la balance des blancs après avoir travaillé en éclairage artificiel en repassant à l’éclairage naturel ;

-etc.

(personnellement, je ne touche jamais à la balance des blancs du boîtier mais cela n’engage que moi ! Ca m’évite juste de m’embêter… et comme je vais le montrer, le résultat avec la méthode que je préconise est normalement meilleur).

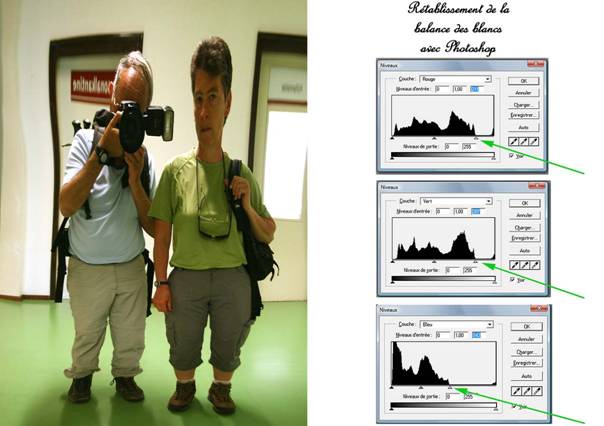

Le rétablissement de la balance des blancs se fait très simplement à l’aide d’une action sur les histogrammes par couleur. Il s’agit d’un des « traitement dans l’espace des couleurs » qui seront détaillés au chapitre 4. Il suppose que la photo ne présente pas déjà des zones surexposées au point d’être toutes blanches sans dominante ; même dans ce cas, si ces zones sont limitées, on peut encore procéder à l’opération décrite ici sans espoir bien sûr de les récupérer. Elle est présentée ci-dessous sous forme d’une illustration :

Dans certaines versions de Photoshop® et dans GIMP2.6®, les histogrammes sont accessibles sous le nom de « Niveaux ».

L’image ci-dessus est celle après rétablissement de la balance des blancs (pour voir ce qui a été fait, regarder les flèches vertes). La qualité du résultat obtenu peut par exemple être jugée par le côté blanc de la porte à gauche des personnages (autoportrait dans une glace déformante…) : ce côté présentait une dominante jaunâtre avant l’opération. Le rectangle vitré dans la porte de droite était déjà surexposé (et sans intérêt), il apparaissait sur la droite des histogrammes sous forme d’un petit pic ; il n’en a pas été tenu compte.

Anticipant sur le chapitre suivant, si l’on rétablit la balance des blancs à l’aide des histogrammes, tant qu’on y est, il est judicieux de regarder si quelques corrections sur l’histogramme général n’améliorent pas le cliché. D’une part il s’agit d’un traitement approprié et qui vient là à sa place. D’autre part, il est possible que le rétablissement de la balance des blancs éclaircisse trop le cliché et qu’une bonne dynamique soit rétablie en jouant ensuite sur l’histogramme général.

La justification technique de ce mode de correction de la balance des blancs est

élémentaire à partir du moment où l’on a assimilé comment fonctionne l’espace

des couleurs et ce que sont les histogrammes par couleur.

Il faut considérer que,

sur une photo « normalement constituée », les pixels les plus clairs

doivent être blancs ou en tout cas non colorés (d’un gris neutre). C’est bien

ce que l’on recherche quand on dit « rétablir la balance des blancs »

et c’est ce qui satisfait notre œil et surtout notre cerveau qui, en dehors de

tout procédé photographique, arrivent à « voir blanche » une feuille

de papier blanc éclairée par une lumière électrique à dominante jaune qui en

fait une feuille jaune sans que nous en soyons conscients... Quelle que soit la

lumière, électrique courante, lampe 3000°K, néon, solaire, etc., on espère

ramener la plage la plus lumineuse à un blanc ou, à tout le moins, à un gris

neutre. C’est même le cas avec des éclairages colorés comme les lampes à vapeur

de sodium… sauf, encore une fois, si l’on recherche un effet particulier. Si

l’on veut conserver une couleur jaune pour avoir une ambiance d’intérieur sur une

photo prise avec la lumière électrique courante, il n’est plus question de

balance des blancs et cela n’a plus rien à voir avec ce que j’explique ici.

Il faut bien être

conscient que, curieusement, pour un document que l’on va imprimer,

« rétablir la balance des blancs », c’est obtenir une couleur aussi

neutre (grise ou blanche) que celle de la feuille (blanche) sur laquelle on va

imprimer. Après, l’éclairage sous lequel on regardera le document peut faire

que le blanc soit jaune (cas le plus fréquent avec les éclairages électriques

traditionnels).

Les pixels les plus

clairs sont, dans les trois couleurs, ceux qui sont représentés le plus à

droite de l’histogramme (et donc les plus proches de 255, le blanc pur étant

réservé à des pixels de valeur 255,255,255). Quand on fait la manipulation que

j’ai indiquée précédemment, on ramène tout simplement ces pixels les plus

clairs à 255 dans les trois couleurs, donc on les amène à la valeur

« blanc ». Pour notre œil, on a donc rétabli la balance des

blancs : les pixels les plus clairs sont redevenus blancs comme la feuille

sur laquelle ils seront imprimés (et qui ne recevra pas d’encre à leur niveau…).

Tout le reste de l’image suit. Non seulement cette manipulation est très simple, mais elle est en principe plus

précise que d’utiliser soit les fonctions du boîtier concernant la balance des

blancs, soit celles du logiciel de traitement d’image, par exemple avec des

températures de couleur. En effet, elle permet de rétablir la balance des

blancs très précisément et en conformité avec sa définition, même avec des

éclairages composites ou des lampes n’éclairant pas avec une répartition

conforme à la courbe du corps noir, alors que dans ces cas, très courants pour

ne pas dire généraux, la notion de température de couleur n’a plus aucune

signification physique !

Par contre, ce procédé

ne marche plus dans trois cas :

-celui d’une photo

très surexposée pour laquelle on a déjà un nombre important de pixels à

256,256,256 (mais est-ce bien raisonnable de vouloir sauver à tout prix une

photo à la fois complètement surexposée et présentant des dérives de

couleur ? Si l’on y tient vraiment, on peut toujours travailler « à

vue de nez » sur les histogrammes pour essayer d’obtenir les résultats

évoqués ci-dessus ; dans le cas où les plages saturées sont bien séparées du

reste de la photo, on peut même parfois réaliser l’opération que je recommande

pour rétablir la balance des blancs sur le reste des histogrammes ; on ne

sauvera pas ce qui est saturé car c’est impossible, mais on pourra encore

obtenir une très honnête balance des blancs pour le reste de la photo ;

c’est même ce que j’ai fait sur la photo présentée en exemple ci-dessus :

le rectangle blanc de la porte à droite derrière les personnages est saturé

mais n’empêche pas le rétablissement de la balance des blancs pour le

reste ; on voit clairement sur les histogrammes qu’il y a des pixels à 255

dans les trois couleurs)

-celui d’une photo

présentant une dominante colorée du fait du sujet, mais il n’est plus question

de balance des blancs dans ce cas, illustré par l’exemple ci-après.

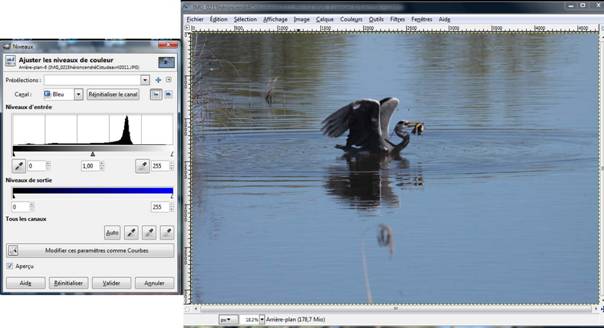

Ci-dessus, une photo et son histogramme dans

le bleu. On voit que celui-ci va de 0 à 255. Un histogramme est en fait

constitué de 256 barres verticales dont la hauteur est proportionnelle au

nombre de pixels de la photo qui prennent la valeur correspondante dans le

bleu. Ici, l’histogramme du bleu présente un pic vers la valeur 180, ce qui

correspond bien évidemment aux pixels de

toute la zone d’eau, très bleue.

-je n’évoque ici que pour mémoire le

troisième cas : celui d’un éclairage tellement hétérogène que les diverses

zones de la photo ont des dominantes différentes. J’y ai personnellement été

confronté dans le cas de macrophotos à très fort grossissement sur statif avec

des éclairages variés (à la fois fibres optiques et lumière du jour se

combinant). Il est bien évident que dans ce cas, c’est le mode opératoire qui

est à revoir et que le traitement d’image n’y peut pas grand chose.

Pour terminer cette anticipation sur les

histogrammes, il faut évoquer ici ce

qu’est l’histogramme général et l’interprétation qui peut en être faite

vis-à-vis du contenu de la photo.

Dans Photoshop®

(jusqu’à CS6 en tout cas), l’histogramme général de la fonction

« Niveaux », c’est-à-dire sur les trois couleurs à la fois est obtenu

d’une manière inhabituelle. Il s’agit d’une superposition des valeurs de chaque

pixel dans les trois couleurs codée entre 0 et 255.Il ne s’agit plus d’un

histogramme au sens mathématique du terme (et c’est bien dommage !). L’interprétation

en devient très ardue, parfois inutilisable… En effet, si un véritable histogramme était une courbe

bimodale (au sens des probabilités, ce qui est un cas banal en photographie si

l’on a par exemple une surface de terre un peu sombre et dans les tons bruns et

une surface de mer ou de ciel à dominante bleue), combinés avec les pics par

couleur, ces 2 « modes » peuvent conduire à avoir jusqu’à 6 pics sur

ce pseudo histogramme et il devient quasiment impossible de s’y

retrouver !

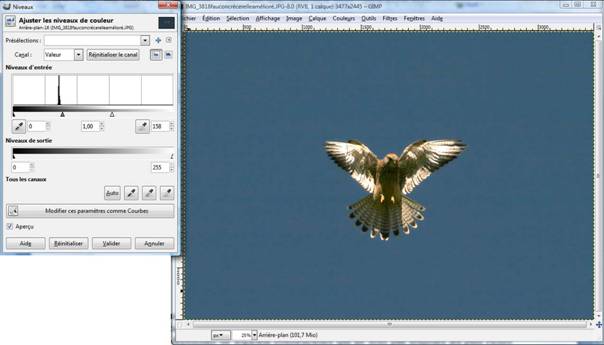

La photo ci-dessus

d’un faucon crécerelle à contrejour montre trois pics bien marqués dans

l’histogramme. Les trois pics correspondent à l’immense majorité des

pixels : ceux du ciel. Celui de gauche correspond au pic dans le rouge (le

plus sombre : il n’y a guère de rouge dans le ciel…), celui du milieu au

vert et celui de gauche, donc le plus

lumineux, au bleu (normal, le ciel est bleu, même s’il ne s’agit pas

d’un bleu « pur »…). Il n’y a pas de « modes » au sens des

probabilités bien qu’on croit visuellement avoir affaire à une courbe trimodale

(fausse…).

Comme indiqué, l’histogramme

ci-dessus a été réalisé avec Photoshop®. Ci-dessous, la même opération avec

GIMP2® ne donne pas du tout le même résultat. En effet, le graphique que

présente ce logiciel est un véritable histogramme calculé sur

la « luminosité », valeur liée à chaque pixel et calculée d’une manière parfaitement

définie en fonction des valeurs dans les trois canaux.

A noter qu’il en va de

même avec les « informations » que peuvent afficher les boîtiers

photos à propos d’un cliché donné. Je n’ai pas eu le loisir de vérifier pour

tous les constructeurs mais la notice du CANON® EOS 7D indique par exemple très

clairement que le calcul de l’histogramme général est fait sur la luminosité, comme

pour GIMP2®. Il en va de même avec les boîtiers NIKON® et SONY® auxquels j’ai

eu accès.

4.Deuxième

phase de traitement. Travail dans l’espace des couleurs.

Dans les logiciels de traitement d’image, il existe de nombreuses fonctions travaillant uniquement dans l’espace des couleurs. Leur nom peut varier quelque peu d’un logiciel à l’autre. Ce sont par exemple : Niveaux (ou histogrammes, évoqués précédemment), Courbes, Balance des couleurs, Luminosité, Contraste, Teinte, Saturation, etc. Il existe également parmi les trucs de photographes d’autres procédures consistant à superposer des calques plus ou moins traités en jouant sur l’opacité (je ne parle pas ici de détourer telle ou telle zone du cliché pour la traiter séparément mais simplement de recombiner des calques d’une même photo après avoir fait subir à certains d’entre eux divers traitements du même type que ceux que je présente ici). Il existe enfin des méthodes professionnelles d’analyse automatique ou semi-automatique d’image dans l’espace des couleurs bien maîtrisées depuis plusieurs décennies (mises au point à la fin des années 70 et au début des années 80 pour les besoins du traitement des images de satellite).

Le sujet n’est donc pas de se perdre dans cette jungle ni de tester tout et n’importe quoi. Il est préférable de se donner une « politique » de traitement qui évite de créer des redondances ou de dégrader les images par la multiplication des traitements ou par des traitements inadéquates.

J’élimine d’emblée le travail sur les calques superposés pour trois raisons ;

-d’une part, il est bien difficile de le rattacher à des algorithmes théoriques qui tiennent debout ; en un mot, il s’agit surtout de travail par essai et erreur mais sans vraiment savoir où l’on va, du bidouillage dangereux donc ;

-d’autre part, il est plus difficile à maîtriser car il demande de gérer des structures complexes qui ne se justifient pas ;

-mais surtout, en multipliant les calques, on multiplie aussi les dégradations de l’image initiale, ce qui va à l’encontre du but recherché ; en un mot, il convient de choisir des solutions simples, maîtrisées et qui dégradent moins.

Je ne décris pas ce genre de traitement, non parce que je traite ici d’une manière élémentaire de faire du traitement de photo, alors que le travail par calques serait supposé plus complexe. La raison n’est pas non plus que je ne le maitrise pas : on pourra s’en assurer en réfléchissant à la manière dont j’ai dû procéder pour fabriquer certaines illustrations du présent texte et surtout le Power Point® qui va avec : j’ai pour cela utilisé très abondamment les calques dans un domaine pour lequel ils ont justement été conçus. La seule raison est que je considère cette manière de travailler comme nuisible.

Pour ce qui est de détourer des zones et de les traiter séparément, je ne traite pas ce sujet ici. Je l’évoquerai très rapidement au niveau du chapitre 6. sur les retouches.

Dans un autre registre, j’élimine les logiciels d’analyse car ils ne sont pas, à ma connaissance, disponibles sur le marché des logiciels de traitement des photos. Les ayant beaucoup pratiqués, je pense qu’ils pourraient apporter quelque chose d’intéressant dans des cas assez variés même s’ils sont un peu plus complexes que les traitements simples que je vais décrire maintenant.

Il reste donc les autres qui sont déjà bien nombreux. On peut les séparer en deux catégories :

-ceux qui sont très facilement susceptibles de saturer en blanc ou en noir certaines zones qui ne l’étaient pas ;

-ceux qui, bien utilisés, ne risque pas trop ce genre de chose.

Les deux sont utiles et à utiliser suivant les cas de figure. Parmi les traitements cités ci-dessus, dans la première catégorie, on trouve : Luminosité, Contraste, Teinte, Saturation et dans la deuxième catégorie : Niveaux (histogramme), Courbes, Balance des couleurs. Parmi eux, j’en retiens quelques-uns qui me semblent assez bien couvrir la palette de ce que peut nécessiter le traitement habituel d’une photo (et qui sont ceux que j’utilise habituellement, même si je me rabats parfois sur d’autres).

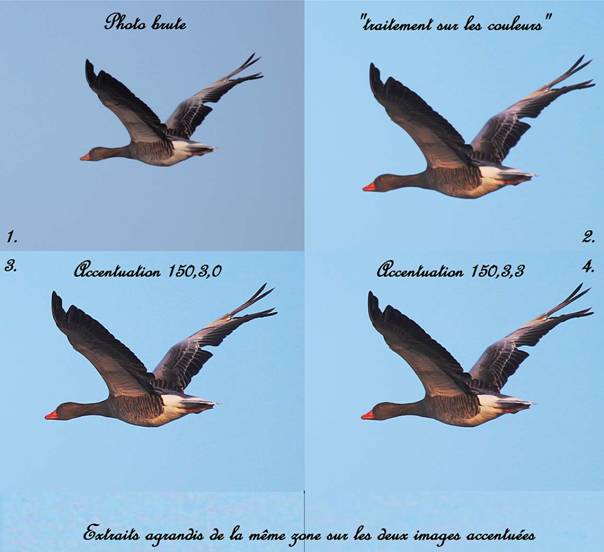

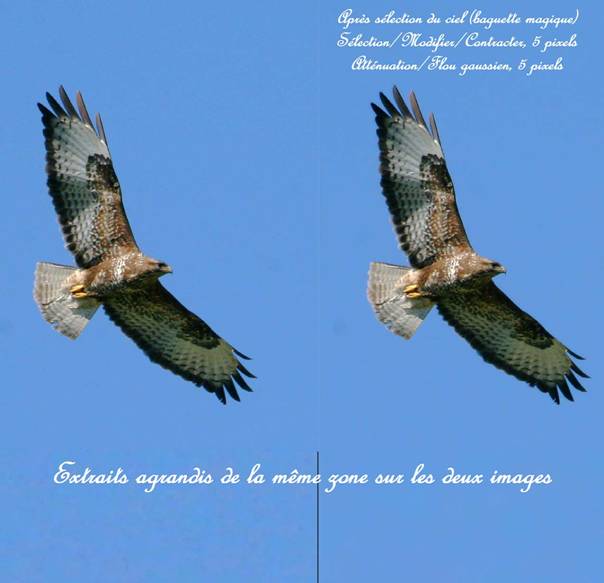

Je ne reparle de la fonction Histogramme (Niveaux) que pour mémoire, en ayant déjà abondamment parlé à la fin du chapitre précédent. Au niveau du traitement de la photo, elle présente surtout l’avantage de montrer comment la photo est structurée… à condition d’en avoir déjà une certaine habitude. On peut par exemple voir si certaines zones sont saturées en blanc (« cramées ») ou en noir. Si certaines zones sont saturées, l’histogramme « bute » sur la droite ou sur la gauche (voire des deux côtés, mais c’est beaucoup moins probable : on n’imagine guère une photo à la fois surexposée et sous-exposée, sauf traitement particulièrement loupé !). Le travail sur l’histogramme, outre le rétablissement de la balance des blancs détaillé précédemment, permet certaines améliorations des photos, assez limitées mais qui ont au moins le mérite de ne pas accroître les zones saturées, sauf manipulation vraiment maladroite… A noter qu’on peut vérifier cela dès la prise de la photo surl’écran LCD de la plupart des boîtiers.

4.1.Photos ne présentant pas de zones

saturées en blanc ou en noir.

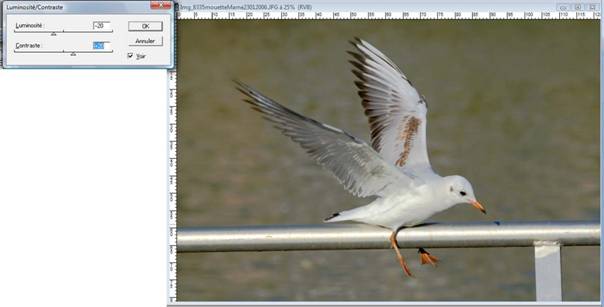

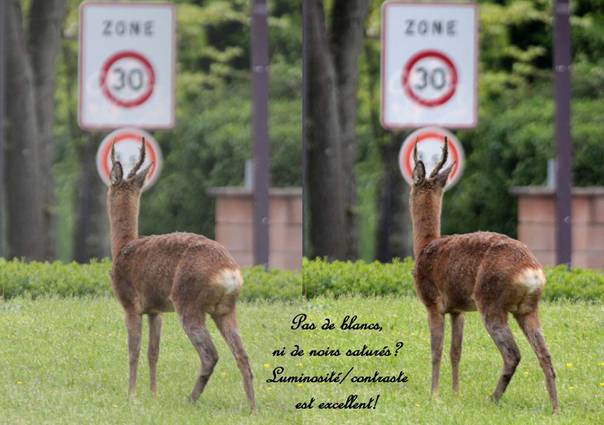

Un tandem de traitements qui permet des améliorations appréciables est alors Luminosité/Contraste… en faisant bien attention de ne pas créer des zones saturées là où il n’y en avait pas.

Un petit traitement complémentaire en jouant sur Saturation peut apporter un petit plus (mais attention au risque d’amplification, voire de création, de bruit).

4.2.Photos présentant des zones qui

semblent saturées en blanc ou en noir.

Si la saturation est dans les tons sombres, il y a peu d’espoir de pouvoir « repêcher » la photo. En effet, même si elles existent, la mise en évidence de nuances dans les tons sombres risque fort de créer immédiatement un bruit insupportable là où celui-ci préexistait mais n’était pas visible.

Photos qui présentent des zones qui semblent saturées en blanc. Si elles le sont vraiment, avec des pixels à 256,256,256, elles le resteront. Par contre, si les pixels ont des valeurs un peu inférieures, on peut espérer récupérer des « nuances cachées ». De même, cela pourra se produire à la périphérie des zones complètement saturées, permettant ainsi une amélioration parfois considérable. Par contre, Luminosité/Contraste risque fort d’aggraver la situation sauf peut-être dans le cas d’une photo surexposée dont on va diminuer la luminosité.

La fonction Courbes est alors parfaitement adaptée. Elle demande certes un peu de doigté quand on l’utilise sur l’ensemble des trois couleurs. Quant aux options par couleur je les déconseille carrément car, à moins d’être un virtuose, on risque fort que la photo n’en ressorte pas indemne… Il faut comprendre cette fonction comme jouant de l’accordéon avec les plages d’intensité lumineuse des pixels. Par exemple, si l’on donne un « coup d’accordéon » pour étaler les zones les plus claires, on pourra espérer voir apparaître des nuances dans des zones qui paraissaient « cramées ». Bien entendu, cela sera probablement au détriment du reste de la photo qui risque fort de perdre des nuances.

Globalement, dans de nombreux cas, on récupérera à la sortie de la fonction Courbes une image qui a retrouvé ses nuances dans les zones qui n’en présentaient pas mais qui semble devenue plus terne ou affadie. Cela est normal ! En effet, ayant fait ressortir visuellement certaines zones sans nuances par un « coup d’accordéon » sur l’ensemble, il est normal qu’on en affadisse d’autres par contrecoup. Cela n’est pas grave dans la mesure où l’utilisation d’une, voire deux autres fonctions pourront redonner de la dynamique au cliché. Le plus simple est d’essayer avec Saturation qui donne souvent de bons résultats en la matière. Si cela ne suffit pas, on peut aussi essayer avec Contraste de Luminosité/Contraste… avec toute la légèreté nécessaire pour ne pas « re-cramer » des zones qui avaient livré leurs nuances… Dans certains cas, on n’arrivera pas à s’en sortir… mais je n’ai pas trouvé à ce jour de logiciel intégrant la fonction Miracles qui permettrait de faire une bonne photo avec un truc loupé !!!... (celui qui la commercialise le premier est sûr de faire immédiatement fortune !).

Le traitement de cette mouette avec les fonctions que j’indique, en commençant par Courbes ne permet pas de résultat miraculeux mais une amélioration nette du corps de la mouette qui était un peu trop saturé dans l’original.

Il faut bien être conscient qu’outre la

nécessité du doigté requis, on n’aura jamais une photo plus contrastée tout en

ayant sorti de l’information de zones qui paraissaient saturées. Il faut

choisir entre les deux.

Il serait faux de croire que des astuces telles que séparer un calque du fond et un de la mouette pourrait améliorer la photo. Outre que de tels traitements étaient prohibés dans les concours où elle a été présentée, on serait sûr de créer des effets de bord désastreux et/ou de perdre la finesse du flou du bout des ailes qui marque le mouvement dans les photos d’oiseaux en vol. Ou alors, il faudrait traiter pixel par pixel, sans trop savoir où l’on va, ce qui, avec les boîtiers modernes de 10 à 20 mégapixels et plus, devient un travail colossal pour un résultat aléatoire (et prohibé dans les concours de photos de nature…)

Exemple quand il n’y a pas de zones saturées :

En résumé, j’utilise personnellement

suivant les situations deux séries de traitements :

-soit

Luminosité/Contraste puis un éventuel petit coup de Saturation ;

-soit Courbes puis

Saturation et éventuellement un peu de Contraste, voire de Luminosité.

Bien entendu, si l’on ne s’en sort pas de cette manière, on peut toujours essayer toutes les autres méthodes une par une… mais il y a fort à parier qu’on n’obtiendra pas grand-chose de mieux car elles sont toutes plus ou moins redondantes et leur principe est toujours à peu près le même.